W odpowiedzi na rosnące wymagania nowoczesnych środowisk produkcyjnych, systemy wizyjne stają się fundamentalnym elementem architektury robotów współpracujących (cobotów), umożliwiając akwizycję i przetwarzanie danych wizualnych w czasie rzeczywistym na potrzeby bezpiecznej interakcji człowiek-robot (HRI)

To właśnie przełomowe osiągnięcia w dziedzinie widzenia maszynowego pozwalają na osiągnięcie bezprecedensowej precyzji i niezawodności w aplikacjach przemysłowych - od montażu mikroelektroniki, przez złożone operacje pick-and-place, aż po zaawansowaną inspekcję jakości. Implementacje systemów wizyjnych nowej generacji przekładają się na mierzalne korzyści: wzrost dokładności operacji, znaczącą redukcję defektów oraz możliwość adaptacji do zmiennych warunków produkcyjnych.

W niniejszym artykule przeprowadzimy szczegółową analizę techniczną systemów wizyjnych dla cobotów - od zaawansowanych układów optyczno-elektronicznych, poprzez algorytmy przetwarzania obrazu wykorzystujące najnowsze osiągnięcia w dziedzinie AI/ML, aż po integrację systemową w warunkach przemysłowych. Szczególną uwagę poświęcimy krytycznym parametrom jak latencja systemu, precyzja kalibracji przestrzennej oraz odporność na zakłócenia, ilustrując rozważania przykładami wdrożeń z wiodących zakładów produkcyjnych.

Dlaczego systemy wizyjne są tak ważne?

Aby coboty mogły efektywnie funkcjonować w dynamicznym środowisku produkcyjnym, muszą zostać wyposażone w systemy wizyjne, które pełnią funkcję ich “oczu”. Te systemy umożliwiają robotom nie tylko wykonywanie złożonych operacji, ale też szybkie reagowanie na zmiany w otoczeniu i interakcję z ludźmi. Oto kluczowe funkcje, jakie spełniają systemy wizyjne cobotów:

- dokładne rozpoznawanie obiektów i ich położenia,

- precyzyjne wykonywanie operacji montażowych,

- kontrolę jakości produktów,

- bezpieczną interakcję z ludźmi.

Zdolność do wykonywania takich procesów nie jest trywialnym zadaniem – wymagane jest tutaj rozwiązanie wizyjne, czyli połączenia hardware (kamera, obiektyw, oświetlenie) oraz software (zarówno tego odpowiedzialnego za sterowanie kamerą, analizę obrazu oraz komunikacji z robotem). Przyjrzyjmy się teraz budowie I funkcji tych komponentów.

Architektura optyczna systemu wizyjnego

Zacznijmy od podstaw, czyli z czego składa się przemysłowy system wizyjny. Architektura optyczna determinuje fundamentalne możliwości systemu wizyjnego, wpływając bezpośrednio na jakość akwizycji danych przestrzennych i dokładność detekcji obiektów. W kontekście robotów współpracujących, precyzyjne odwzorowanie przestrzeni roboczej ma kluczowe znaczenie dla bezpieczeństwa interakcji człowiek-robot oraz jakości wykonywanych zadań.

Kamera – tzn. body

Kamery 2D

Kamery 2D to najprostsze i najczęściej spotykane rozwiązanie w systemach wizyjnych, które rejestrują obraz w dwóch wymiarach — wysokości i szerokości. Kamery te dostarczają klasycznego obrazu płaskiego, bez informacji o głębi, co oznacza, że postrzegają obiekty tak, jak robi to ludzkie oko patrzące na płaską powierzchnię. Kamery 2D są idealne do zadań, gdzie istotna jest analiza powierzchniowa, detekcja kolorów, wykrywanie defektów powierzchniowych czy rozpoznawanie kodów i etykiet. W systemach wizyjnych często współpracują z technologiami oświetleniowymi, które wzmacniają kontrast i poprawiają widoczność detali na obrazie.

Zastosowania

Kamery 2D są szeroko stosowane w procesach inspekcyjnych, gdzie wymagana jest analiza płaskich powierzchni pod kątem defektów, takich jak rysy, przebarwienia, lub nierówności. Sprawdzają się również w zadaniach odczytu kodów kreskowych i etykiet na linii produkcyjnej, gdzie liczy się precyzyjna identyfikacja i klasyfikacja produktów.

Typowe parametry spotykanie w przemyśle:

- Sensory: CMOS/BSI-CMOS o rozdzielczości 2MP-20MP przy bitowej głębi 8/10/12-bit - wyższa rozdzielczość jest kluczowa w aplikacjach wymagających detekcji submilimetrowych defektów, np. w kontroli jakości układów elektronicznych

- Częstotliwości akwizycji: 60-200 fps dla full frame, do 1000+ fps w trybie ROI - szybka akwizycja umożliwia śledzenie dynamicznych procesów i kompensację drgań robota

- Dynamic range: 70-90 dB (HDR do 120 dB w trybie multi-exposure) - szeroki zakres dynamiki jest niezbędny w środowiskach o zmiennym oświetleniu, np. przy inspekcji elementów odbijających światło

- Przesłona: Global shutter eliminuje zniekształcenia przy szybkim ruchu robota, co jest krytyczne np. podczas operacji pick-and-place przy wysokich prędkościach

Kamery 2.5D

Kamery 2.5D, często określane jako kamery głębi, dostarczają więcej informacji niż kamery 2D, łącząc klasyczny obraz płaski z pomiarem głębokości. Dzięki temu mogą mierzyć wysokość poszczególnych punktów na obrazie, co umożliwia analizę jednowymiarowej głębi. Kamery 2.5D pozwalają więc nie tylko na rozpoznanie obiektów, ale także na określenie ich relatywnej wysokości. Jest to szczególnie przydatne w aplikacjach, gdzie niezbędna jest segregacja obiektów o różnych wysokościach lub identyfikacja położenia obiektów na jednej płaszczyźnie.

Zastosowania

Kamery 2.5D znajdują zastosowanie w zadaniach takich jak paletyzacja, depaletyzacja oraz sortowanie obiektów o różnych wysokościach. W przypadku cobotów kamery te wspierają zadania, w których ważna jest ocena różnic wysokości między obiektami, co przekłada się na większą precyzję operacji montażowych i manipulacyjnych.

Typowe parametry spotykanie w przemyśle:

- Rozdzielczość obrazu: typowo w zakresie od 640x480 do 1920x1080 pikseli, zapewniająca wyraźne odwzorowanie szczegółów powierzchni.

- Dokładność głębi: dokładność pomiaru głębi wynosi zwykle od 0,1 mm do 2 mm, co jest wystarczające do zadań takich jak sortowanie lub kontrola wysokości.

- Zakres głębi: przeważnie od kilku centymetrów do około 1 metra, co sprawia, że kamery te nadają się do zastosowań, w których wymagany jest ograniczony zakres głębi.

- Prędkość rejestrowania: najczęściej od 15 do 30 klatek na sekundę (fps), co pozwala na rejestrowanie obrazu w czasie rzeczywistym w aplikacjach przemysłowych, takich jak paletyzacja i detekcja wysokości.

Kamery 3D

To najbardziej zaawansowane narzędzie w systemach wizyjnych, dostarczające pełnej informacji przestrzennej o obiektach i ich otoczeniu. W przeciwieństwie do kamer 2D i 2.5D, kamery 3D analizują głębię w pełnym zakresie, co umożliwia dokładne odwzorowanie kształtów, orientacji i położenia obiektów w przestrzeni trójwymiarowej. Kamery te wykorzystują technologie takie jak stereo-wizja, skanowanie laserowe czy światło strukturalne, które pozwalają na generowanie precyzyjnych trójwymiarowych modeli. W efekcie kamery 3D są niezastąpione w aplikacjach wymagających szczegółowej analizy przestrzennej oraz w złożonych zadaniach montażowych.

Przykłady zastosowania

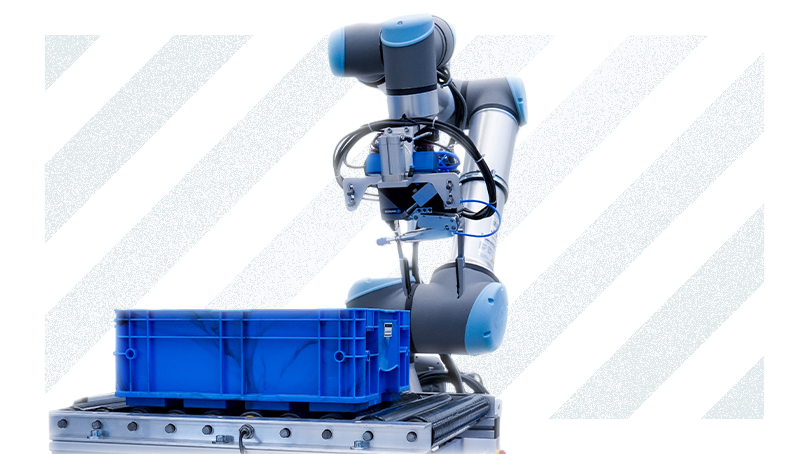

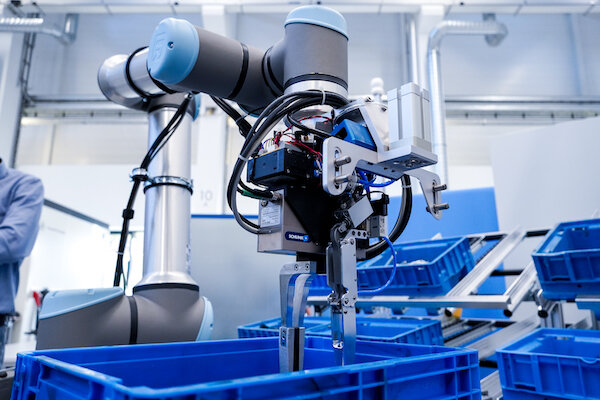

Kamery 3D są powszechnie stosowane w zaawansowanych zadaniach, takich jak bin picking, czyli wybieranie obiektów losowo ułożonych w pojemnikach. W tego typu zadaniach kamery 3D pozwalają cobotom na ocenę kształtów i orientacji każdego obiektu, co umożliwia bezpieczne i precyzyjne chwytanie oraz dalsze przetwarzanie. W inspekcji produkcyjnej kamery te umożliwiają analizę struktury obiektów i identyfikację wszelkich anomalii, takich jak deformacje i uszkodzenia.

Typowe parametry spotykanie w przemyśle

- Rozdzielczość obrazu: typowa rozdzielczość wynosi od 640x480 do 1280x1024 pikseli. W przypadku zaawansowanych kamer przemysłowych możliwe są także wyższe rozdzielczości, ale większość systemów 3D koncentruje się na dostarczaniu precyzyjnych danych głębi, a nie detali obrazu.

- Dokładność głębi: dokładność zależy od technologii kamery. Przykładowo, w systemach światła strukturalnego czy kamerach stereo dokładność pomiaru głębi wynosi zwykle od 0,1 mm do 1 mm na krótkie dystanse (do 1 metra). W przypadku większych dystansów dokładność może spadać, osiągając wartości rzędu kilku milimetrów na dystansie kilku metrów.

- Zakres głębi: w zależności od zastosowanej technologii zakres głębi w kamerach 3D może wynosić od kilkunastu centymetrów do około 5 metrów w przypadku kamer opartych na świetle strukturalnym i od 0,5 do 10 metrów w kamerach stereo. Kamery Time-of-Flight (ToF) mogą osiągać zasięg nawet do 10-20 metrów, ale przy mniejszej precyzji.

- Prędkość rejestrowania: kamery 3D zazwyczaj działają z prędkością 15–30 klatek na sekundę (fps) w trybie głębi, co pozwala na analizę przestrzenną w czasie rzeczywistym w większości zastosowań przemysłowych. Kamery ToF mogą osiągać wyższe prędkości, nawet do 60 fps, choć jest to zależne od rozdzielczości i warunków oświetleniowych.

Skanery laserowe

Jest jeszcze jedna, dodatkowa kategoria systemów wizyjnych: skanery laserowe. W tym przypadku nie rejestrujemy obrazu w formie pikseli na płaszczyźnie lub w przestrzeni, a badamy deformacje projektowanego odcinka swiatła laserowego. Na tej podstawie generowany jest profil badanej powierzchni. Wyróżniają się wyjątkową dokładnością i szybkością.

Zastosowania

Skanery laserowe są niezastąpione w kontroli jakości spoin, gdzie wymagana jest sub-milimetrowa dokładność pomiaru geometrii. Dzięki szczegółowej analizie 3D można wykrywać wady, takie jak porowatość, nieciągłości czy asymetrie spoiny, zapewniając tym samym wysoką jakość połączeń. Dodatkowo, skanery laserowe umożliwiają adaptacyjne prowadzenie ścieżki robota. W czasie rzeczywistym analizują powierzchnię i dostosowują trajektorię ruchu, co pozwala na precyzyjne nakładanie materiału nawet na nieregularnych powierzchniach, co z kolei poprawia jakość wykonania i minimalizuje ryzyko błędów.

Typowe parametry spotykanie w przemyśle:

- Częstotliwość próbkowania

Skanery laserowe mogą pracować z częstotliwością próbkowania od 2000 do 5000 Hz, co umożliwia szybkie skanowanie powierzchni w ruchu. Dzięki temu są w stanie analizować obiekty na liniach produkcyjnych bez konieczności zatrzymywania ich, co znacząco zwiększa wydajność procesu. - Precyzyja profilowania 3D

Dokładność skanerów laserowych wynosi zazwyczaj od 20 do 50 mikrometrów (μm), co pozwala na szczegółową analizę struktury powierzchni i identyfikację defektów geometrycznych, takich jak niewielkie pęknięcia, deformacje, czy różnice w wysokości. Taka precyzja umożliwia inspekcję jakości elementów, gdzie nawet najmniejsze odchylenia mogą wpłynąć na wydajność lub bezpieczeństwo produktu. - Długości fali lasera

Skanery laserowe oferują możliwość wyboru długości fali (np. 650 nm, 785 nm, 850 nm), co umożliwia dostosowanie pomiarów do specyficznych właściwości materiału, takich jak absorpcja i odbicie światła. Wybór odpowiedniej długości fali pomaga zminimalizować szumy i poprawić jakość pomiaru na materiałach o różnej strukturze lub kolorze.

Obiektywy

Obiektywy przemysłowe, często niedoceniane w całym systemie wizyjnym, stanowią krytyczny element wpływający na jakość i dokładność realizowanych zadań. To właśnie przez ich pryzmat cobot "widzi" świat i podejmuje decyzje wykonawcze. Współczesny rynek obiektywów przemysłowych oferuje szereg wyspecjalizowanych rozwiązań, dostosowanych do różnych technologii wizyjnych.

W systemach 2D dominują obiektywy stałoogniskowe, gdzie kluczową rolę odgrywa precyzja wykonania elementów optycznych. Charakteryzują się one zoptymalizowaną konstrukcją minimalizującą aberracje, co przekłada się na wierne odwzorowanie geometrii obserwowanych obiektów. Szczególnie istotna jest tu korekcja dystorsji - zniekształceń geometrycznych, które mogłyby prowadzić do błędnych pomiarów.

W przypadku systemach 2.5D, wykorzystujących strukturalne oświetlenie do rekonstrukcji wysokości, stosowane są specjalistyczne obiektywy o podwyższonych parametrach transmisji światła. Ich konstrukcja optyczna musi zapewniać nie tylko minimalne zniekształcenia, ale również odpowiednią głębię ostrości w całym zakresie pomiarowym. Kluczowa jest tu równomierność oświetlenia w całym polu widzenia, co przekłada się bezpośrednio na dokładność rekonstrukcji trójwymiarowej.

Najbardziej zaawansowane technologicznie są obiektywy dedykowane do systemów 3D. W przypadku stereowizji wymagane jest stosowanie par idealnie sparowanych obiektywów, których parametry optyczne muszą być niemal identyczne. Specjalistyczne powłoki antyrefleksyjne i precyzyjna kontrola dyfrakcji światła pozwalają na uzyskanie obrazów o wysokim kontraście, niezbędnym do dokładnej rekonstrukcji trójwymiarowej.

Na szczególną uwagę zasługują obiektywy telecentryczne, które eliminują błędy perspektywiczne i zapewniają stałe powiększenie niezależnie od odległości obiektu. To rozwiązanie, choć kosztowne, staje się standardem w aplikacjach wymagających najwyższej precyzji pomiarowej.

Współczesne obiektywy przemysłowe to zaawansowane konstrukcje optyczne, których parametry są optymalizowane pod kątem konkretnych zastosowań. Wykorzystują najnowsze osiągnięcia w dziedzinie powłok optycznych, materiałoznawstwa i precyzyjnej obróbki mechanicznej. Ich konstrukcja mechaniczna musi zapewniać nie tylko stabilność parametrów optycznych w zmiennych warunkach środowiskowych, ale również odporność na wibracje i zanieczyszczenia występujące w środowisku przemysłowym.

Przetwarzanie obrazu – klasyczne algorytmy

Wiemy już jak obraz jest pozyskiwany przez system wizyjny, teraz należy się zastanowić, w jaki sposób możemy to wykorzystać w praktyce. Przetwarzanie obrazu jest kluczowym etapem w systemach wizyjnych, który umożliwia cobotom interpretację i analizę zebranych danych wizualnych. Proces ten obejmuje różnorodne algorytmy, od podstawowych operacji przetwarzania wstępnego, takich jak filtracja i kompensacja oświetlenia, po zaawansowane techniki segmentacji, klasyfikacji i rozpoznawania obiektów. Z racji na praktyczny wymiar tego artykułu, przedstawimy cztery najpopularniejsze kategorie algorytmów.

Detekcja krawędzi i kształtów

Filtr Sobela

Filtr Sobela jest jednym z klasycznych filtrów gradientowych stosowanych do wykrywania krawędzi poprzez analizę zmiany intensywności pikseli. Działa, obliczając różnicę intensywności między pikselami w określonych kierunkach (zazwyczaj w kierunkach poziomym i pionowym), tworząc dwie maski: jedną w osi X i drugą w osi Y. Sobel nadaje się do detekcji prostych krawędzi, jednak przy bardziej złożonych kształtach lub obrazach z dużym poziomem szumów może być mniej skuteczny.

- Zastosowania

Inspekcja jakości, wykrywanie podstawowych konturów obiektów na taśmach produkcyjnych.

Filtr Scharra

Filtr Scharra to bardziej zaawansowana wersja filtru Sobela, która oferuje większą dokładność detekcji gradientów, szczególnie w obrazach o niskim kontraście. W przypadku Scharra, maski gradientowe są bardziej skomplikowane, co pozwala na lepszą identyfikację krawędzi przy minimalnym zakłóceniu przez szum.

- Zastosowania

Aplikacje wymagające większej precyzji w detekcji krawędzi, np. precyzyjna kontrola jakości elementów metalowych lub ceramicznych, gdzie obecność małych defektów jest krytyczna.

Algorytm Canny’ego

Algorytm Canny’ego jest jednym z najpopularniejszych algorytmów detekcji krawędzi, ponieważ oferuje wysoką czułość i dokładność przy minimalnym zakłóceniu przez szum. Działa w kilku etapach:

- Filtracja szumów: zastosowanie filtru Gaussa w celu wygładzenia obrazu.

- Obliczanie gradientu: wykrycie zmian intensywności, aby wyznaczyć punkty, gdzie krawędzie są najbardziej wyraziste.

- Non-maximum suppression: zachowuje tylko piksele o najwyższej wartości gradientu, co prowadzi do wyraźniejszej krawędzi.

- Histereza: korzystanie z progów detekcji dolnego i górnego, co pomaga utrzymać ciągłość krawędzi i minimalizować fałszywe detekcje.

- Zastosowania

Canny’ego jest powszechnie stosowany w aplikacjach inspekcyjnych i produkcyjnych, takich jak wykrywanie wad powierzchniowych w produkcji szkła i metalu, a także do rozpoznawania konturów w zadaniach montażowych

Zero-crossing detection

Detekcja zero-crossing bazuje na metodach Laplace’a, co pozwala wykrywać krawędzie, gdzie gradient przechodzi przez zero. Jest to algorytm szczególnie przydatny przy analizie obrazów o wysokim poziomie szumu, ponieważ dobrze separuje krawędzie od tła.

- Zastosowania

Precyzyjna analiza konturów w obrazach o wysokim szumie, takich jak obrazy rentgenowskie lub zdjęcia medyczne, gdzie kluczowa jest dokładna detekcja granic bez zakłóceń.

Transformata Hougha do linii i okręgów

Transformata Hougha pozwala na detekcję obiektów o regularnych kształtach, takich jak linie i okręgi. Działa poprzez przekształcenie punktów na obrazie do przestrzeni parametrycznej, co pozwala na wyszukiwanie odpowiednich kształtów bez analizy każdego pikselu z osobna. Transformata Hougha do linii przekształca wszystkie krawędzie na linie w przestrzeni parametrycznej, a okręgi są wykrywane na podstawie promienia.

- Zastosowania

Wykrywanie elementów cylindrycznych (np. rury, uszczelki) w procesach montażowych i kontrolnych. Detekcja okręgów przydaje się również w inspekcji jakości, np. w przemyśle motoryzacyjnym do weryfikacji rozmiaru i jakości otworów

RANSAC (Random Sample Consensus)

RANSAC to algorytm statystyczny stosowany do dopasowania modeli do zestawów danych, które zawierają szum lub anomalia. Dzięki iteracyjnemu podejściu, RANSAC znajduje parametry modelu poprzez wybieranie losowych podzbiorów danych i testowanie ich na modelu. Jest stosowany m.in. do analizy obiektów o nieregularnych konturach, gdzie szum może wpływać na precyzję detekcji.

- Zastosowania

Stosowany do dopasowywania modeli w obrazach o dużej liczbie niepożądanych punktów, np. przy wykrywaniu uszkodzeń materiałów, pęknięć lub rys w elementach metalowych i kompozytowych.

Segmentacja obrazu

Segmentacja obrazu polega na podziale obrazu na spójne regiony, które można dalej analizować pod kątem określonych cech. Metody segmentacji umożliwiają robotom wydzielanie obiektów z tła oraz klasyfikację różnych części obrazu.

Prosta segmentacja progu

Segmentacja progu (thresholding) jest podstawową metodą, polegającą na przypisaniu pikselom dwóch wartości (binarnych) na podstawie ich intensywności. Próg ustala się manualnie lub dynamicznie, aby odseparować obiekty od tła. Jest to szybka i efektywna metoda, jednak w przypadku złożonych obrazów może nie spełniać swojej roli ze względu na trudności w ustaleniu jednego progu.

- Zastosowania:

Inspekcja jakości na taśmie produkcyjnej, np. separacja defektów na powierzchniach jednobarwnych lub wyodrębnianie obiektów od jasnego tła.

Adaptacyjna segmentacja progu

Adaptacyjna segmentacja progu dostosowuje wartość progu w zależności od lokalnych zmian intensywności na obrazie, co pozwala na efektywne segmentowanie obiektów w warunkach niejednorodnego oświetlenia. W praktyce obraz jest podzielony na mniejsze regiony, a dla każdego z nich ustalany jest osobny próg.

- Zastosowania

Kontrola jakości w zmiennym oświetleniu, np. Inspekcja produktów na linii produkcyjnej o zróżnicowanym oświetleniu lub na obiektach z wieloma odcieniami (np. analizie papieru lub tkanin).

Przestrzeń kolorów HSV

Segmentacja w przestrzeni kolorów HSV (Hue, Saturation, Value) umożliwia bardziej precyzyjne wyodrębnienie obiektów o określonych kolorach niż przestrzeń RGB, ponieważ HSV jest bardziej stabilna wobec zmian intensywności światła. Segmentacja oparta na barwie (hue) pozwala wyodrębnić obiekty niezależnie od oświetlenia, dzięki czemu jest często stosowana w przemyśle, gdzie kolor odgrywa kluczową rolę.

- Zastosowania

Sortowanie produktów na podstawie koloru, np. w przemyśle spożywczym do rozdzielania dojrzałych i niedojrzałych owoców lub w przemyśle tekstylnym do klasyfikacji materiałów według barwy.

Klasteryzacja k-średnich

Algorytm k-średnich dzieli obraz na klastry o podobnych wartościach kolorów, co pozwala na automatyczne grupowanie pikseli. Proces zaczyna się od wyboru losowych centrów klastrów, a następnie przypisywania pikseli do najbliższego centrum. Proces ten jest powtarzany do momentu ustabilizowania się centrów klastrów. Jest to metoda nienadzorowana, co oznacza, że nie wymaga wcześniejszych oznaczeń.

- Zastosowania

W zadaniach klasyfikacyjnych, takich jak rozpoznawanie różnych części lub materiałów na linii montażowej. Na przykład, w produkcji szkła można wykrywać różne kolory szkła i segregować je według jakości lub typu.

Watershed (Segmentacja oparta na topologii)

Metoda Watershed traktuje obraz jak topografię, gdzie intensywności pikseli reprezentują wysokości. Algorytm wyobraża sobie "wypełnianie wodą" obszarów o najniższej intensywności, co pozwala na naturalne wyodrębnienie obiektów. W praktyce stosuje się marker-based watershed, gdzie oznacza się obiekty do segmentacji, co zwiększa precyzję.

- Zastosowania

Analiza produktów o złożonej strukturze, takich jak elektronika, gdzie ważne jest oddzielenie drobnych elementów, lub inspekcja złożonych powierzchni (np. analizowanie spawów).

Algorytmy region-growing (rozrost regionów)

Rozrost regionów to metoda, w której proces segmentacji zaczyna się od określonych pikseli (tzw. nasion) i obejmuje piksele o podobnych cechach w ich sąsiedztwie. Technika ta jest szczególnie przydatna w segmentacji obiektów o jednorodnych właściwościach, gdzie regiony mogą być skutecznie rozszerzane na podobne obszary.

- Zastosowania

Segmentacja materiałów o jednolitej teksturze lub intensywności, np. analiza metalowych powierzchni, gdzie defekty można łatwo odróżnić od tła, lub identyfikacja elementów na obrazach o niskim kontraście.

Detekcja i klasyfikacja obiektów

Detekcja i klasyfikacja obiektów obejmuje algorytmy, które identyfikują i rozróżniają różne obiekty w scenie. Techniki te są niezbędne przy zadaniach takich jak sortowanie, montaż czy inspekcja, gdzie wymagana jest precyzyjna klasyfikacja i lokalizacja.

Template Matching (dopasowanie wzorca)

Template Matching to metoda wykorzystywana do znajdowania określonych wzorców w obrazie. Działa na zasadzie przesuwania szablonu (wzoru) po całym obrazie i dopasowania fragmentów obrazu do wzoru, najczęściej za pomocą korelacji lub miary podobieństwa (np. SSD - Sum of Squared Differences).

- Zastosowania

Weryfikacja obecności i poprawnego ułożenia małych komponentów w procesie montażu. Na przykład, w przemyśle elektronicznym może być stosowany do rozpoznawania specyficznych części, takich jak rezystory i kondensatory na płytach PCB.

Cascade Classifier

Cascade Classifier to algorytm uczony na zestawach pozytywnych i negatywnych przykładów, aby wykrywać obiekty w czasie rzeczywistym. Tworzy się go za pomocą kaskadowego zestawu klasyfikatorów, co pozwala na skuteczne odfiltrowanie obiektów niepożądanych w krótkim czasie. Proces uczenia obejmuje analizę cech (np. z wykorzystaniem Haara), które charakteryzują dany obiekt.

- Zastosowania

Detekcja twarzy lub innych obiektów w złożonych scenach, np. W aplikacjach zabezpieczających, ale także do kontroli obecności obiektów na liniach produkcyjnych.

Przetwarzanie obrazu – algorytmy działające w oparciu o AI

W systemach wizyjnych dla cobotów algorytmy sztucznej inteligencji odgrywają fundamentalną rolę, ponieważ pozwalają robotom na bardziej zaawansowaną analizę obrazu oraz dynamiczną adaptację do zmieniających się warunków pracy. W przeciwieństwie do klasycznych metod, które bazują na określonych operacjach matematycznych i są ściśle zdefiniowane, algorytmy AI, szczególnie te oparte na głębokim uczeniu, mogą automatycznie uczyć się wzorców na podstawie dużych zbiorów danych, co daje im elastyczność i zdolność do rozpoznawania bardziej złożonych struktur i obiektów.

Oto najważniejsze algorytmy AI spotykane w obszarze systemów wizyjnych:

Konwolucyjne sieci neuronowe (CNN)

Sieci CNN są podstawą większości zastosowań AI w wizji komputerowej. Dzięki swojej strukturze opartej na warstwach konwolucyjnych, CNN potrafią analizować różnorodne wzorce na obrazach, takie jak krawędzie, tekstury czy złożone kształty. Sieci te są używane zarówno do klasyfikacji obrazów, jak i do bardziej zaawansowanych zadań, takich jak segmentacja.

- Zastosowania

W systemach wizyjnych dla cobotów CNN pozwalają na precyzyjną klasyfikację produktów na linii produkcyjnej, rozpoznawanie typów komponentów oraz detekcję obiektów na taśmie produkcyjnej.

YOLO (You Only Look Once)

YOLO to algorytm detekcji obiektów, który działa w czasie rzeczywistym, analizując wszystkie regiony obrazu w jednym przebiegu. Dzięki temu może szybko identyfikować obiekty i ich lokalizację, co czyni go idealnym narzędziem do dynamicznych aplikacji w robotyce.

- Zastosowania

YOLO znajduje zastosowanie w aplikacjach takich jak śledzenie obiektów na ruchomej taśmie produkcyjnej oraz szybkie rozpoznawanie i klasyfikacja różnych przedmiotów w czasie rzeczywistym.

Mask R-CNN

Mask R-CNN rozszerza standardowe algorytmy detekcji obiektów o możliwość segmentacji instancji, co oznacza, że każdy wykryty obiekt jest nie tylko zlokalizowany, ale także dokładnie zarysowany. Działa na poziomie pikseli, co pozwala na szczegółowe rozróżnianie elementów na obrazie.

- Zastosowania: Mask R-CNN jest często stosowany w zadaniach montażowych, gdzie wymagana jest wysoka precyzja, na przykład w montażu elementów elektronicznych, gdzie liczy się dokładne pozycjonowanie.

U-Net

Architektura U-Net jest specjalizowaną siecią zaprojektowaną do segmentacji obrazu na poziomie pikseli. Zastosowanie części kodera i dekodera pozwala na dokładną rekonstrukcję szczegółowych obszarów na obrazie, co sprawia, że U-Net jest idealny do zadań wymagających analizy bardzo drobnych detali.

- Zastosowania

U-Net jest często stosowany w systemach wizyjnych cobotów do inspekcji jakości, takich jak detekcja mikroskopijnych wad na płytkach PCB lub identyfikacja defektów na powierzchniach.

AI w przetwarzaniu obrazu – czy zawsze jest konieczne?

W systemach wizyjnych robotów współpracujących (cobotów), zarówno klasyczne algorytmy przetwarzania obrazu, jak i algorytmy sztucznej inteligencji (AI) mają swoje miejsce i zastosowanie. Różnią się jednak podejściem, możliwościami adaptacji oraz wydajnością w różnych warunkach. Kluczowe różnice między tymi dwoma podejściami:

Podejście do analizy obrazu

Klasyczne metody przetwarzania obrazu, takie jak wykrywanie krawędzi (np. algorytm Canny’ego) czy transformata Hougha, opierają się na precyzyjnie zdefiniowanych operacjach matematycznych i algorytmicznych. Działają one według określonego zestawu reguł, które wymagają odpowiednich warunków — np. wyraźnych konturów lub wysokiego kontrastu. Klasyczne algorytmy dobrze radzą sobie z analizą prostych, przewidywalnych kształtów, ale mogą mieć trudności w bardziej złożonych scenariuszach, gdzie obrazy są pełne niuansów, zmian w oświetleniu lub skomplikowanych struktur.

Algorytmy AI, szczególnie te oparte na głębokich sieciach neuronowych, są zdolne do uczenia się wzorców i zasad analizy obrazu na podstawie dużych zbiorów danych. Zamiast korzystać z zestawu sztywnych reguł, sieci neuronowe analizują obrazy na różnych poziomach abstrakcji, od podstawowych kształtów po skomplikowane wzorce. Dzięki temu mogą rozpoznawać obiekty i struktury nawet w zmiennych warunkach, gdzie obrazy są mniej przewidywalne, a struktura bardziej złożona. To pozwala na ich zastosowanie w zróżnicowanych, dynamicznych środowiskach.

Zdolność do adaptacji

Klasyczne algorytmy są stałe – ich działanie opiera się na twardo zaprogramowanych regułach i funkcjach. Oznacza to, że jeśli zmienią się warunki pracy, na przykład oświetlenie, orientacja obiektów czy ich wygląd, algorytmy te często wymagają ponownej kalibracji lub ręcznego dostosowania parametrów. W środowiskach dynamicznych, takich jak linie produkcyjne z wieloma różnorodnymi produktami, klasyczne algorytmy mogą być mniej skuteczne bez regularnych interwencji.

Algorytmy oparte na sztucznej inteligencji mają zdolność do adaptacji. Dzięki technikom takim jak uczenie transferowe, mogą dostosować się do nowych zadań i warunków pracy bez potrzeby pełnego przeprogramowania. Przykładowo, model AI wytrenowany na określonym typie komponentów można łatwo dostosować do analizy nowych obiektów, co czyni algorytmy AI znacznie bardziej elastycznymi i odpornymi na zmiany. To pozwala na ich skuteczne zastosowanie w zmiennych środowiskach produkcyjnych, gdzie często wprowadza się nowe produkty lub zmienia konfigurację.

Złożoność obliczeniowa

Ze względu na swoją strukturę o prostych operacjach matematycznych, klasyczne algorytmy przetwarzania obrazu są z reguły mniej wymagające obliczeniowo. Dzięki temu mogą działać w czasie rzeczywistym na prostym sprzęcie, co sprawia, że są idealne do podstawowych zadań inspekcyjnych i klasyfikacyjnych w środowiskach, gdzie nie ma dostępu do zaawansowanego sprzętu obliczeniowego. Przykłady obejmują systemy kontroli jakości, które wymagają szybkich, ale stosunkowo prostych analiz obrazu.

Algorytmy AI, zwłaszcza te oparte na głębokich sieciach neuronowych, mają znacznie większe wymagania obliczeniowe, szczególnie na etapie trenowania modelu. Ich złożoność wiąże się z koniecznością przetwarzania tysięcy lub nawet milionów parametrów, co wymaga specjalistycznych procesorów (np. GPU lub TPU). Dzięki postępowi w technologii sprzętowej, algorytmy AI mogą być jednak stosowane nawet w czasie rzeczywistym w zaawansowanych aplikacjach przemysłowych, dostarczając bardziej kompleksowych analiz obrazu niż klasyczne metody.

Zdolność do rozpoznawania złożonych wzorców

Klasyczne metody wizyjne mają ograniczoną zdolność rozpoznawania skomplikowanych wzorców. Są skuteczne w zadaniach o dużej przewidywalności, takich jak wykrywanie prostych kształtów czy analiza konturów na obrazie. Jednak gdy obrazy są pełne złożonych detali lub nieregularności, klasyczne algorytmy mogą nie radzić sobie z ich dokładnym rozpoznaniem.

Algorytmy AI, dzięki swojej zdolności do rozpoznawania wzorców na wielu poziomach szczegółowości, mogą analizować skomplikowane struktury na obrazach i rozpoznawać różnorodne kształty. Właśnie dlatego znajdują zastosowanie w zadaniach inspekcji jakości, gdzie wymagana jest detekcja mikroskopijnych wad, takich jak pęknięcia, wgniecenia czy inne nieregularności na powierzchni. Dzięki zdolności do analizowania skomplikowanych i nieprzewidywalnych wzorców, algorytmy AI przewyższają klasyczne metody w sytuacjach wymagających precyzyjnej i szczegółowej analizy obrazu.

Podsumowując, klasyczne algorytmy przetwarzania obrazu doskonale sprawdzają się w prostych i powtarzalnych zadaniach wizyjnych, oferując szybkość i niskie wymagania obliczeniowe. Z kolei algorytmy AI, dzięki zdolności do adaptacji, elastyczności oraz rozpoznawania skomplikowanych wzorców, otwierają nowe możliwości w zaawansowanej automatyce przemysłowej, szczególnie w aplikacjach wymagających wysokiej precyzji, adaptacyjności oraz pracy w dynamicznie zmieniającym się środowisku.

Integracja systemu wizyjnego z robotem współpracujacym

W praktyce przemysłowej dominują dwa główne podejścia do implementacji systemów wizyjnych. Pierwsze z nich opiera się na wykorzystaniu zintegrowanych rozwiązań dostarczanych przez producentów robotów, gdzie system wizyjny jest ściśle powiązany z ekosystemem danego producenta. Drugie podejście zakłada wykorzystanie niezależnych systemów wizyjnych, komunikujących się z robotem poprzez standardowe protokoły przemysłowe. Z racji na ogólny, informacyjny widzwięk tego artykułu, skupimy się na tym drugim podejściu, przekazując ogólny blueprint do wdrożenia systemów wizyjnych.

Technologie komunikacyjne

Kluczowym elementem każdego systemu wizyjnego jest warstwa komunikacyjna. Najczęściej wykorzystywane są protokoły bazujące na Ethernet/IP oraz Modbus TCP/IP, które zapewniają deterministyczną komunikację i są powszechnie wspierane przez producentów sprzętu przemysłowego. W przypadku bardziej zaawansowanych implementacji, coraz częściej spotyka się rozwiązania wykorzystujące protokół OPC UA, który oferuje zaawansowane mechanizmy modelowania danych i bezpieczeństwa.

Architektura rozproszona, gdzie system wizyjny działa na dedykowanym komputerze przemysłowym, staje się standardem w aplikacjach wymagających zaawansowanego przetwarzania obrazu. Takie podejście pozwala na implementację złożonych algorytmów wizyjnych, w tym rozwiązań opartych o sztuczną inteligencję, bez obciążania kontrolera robota. Komunikacja w takiej architekturze często realizowana jest w modelu klient-serwer, gdzie system wizyjny udostępnia usługi poprzez interfejs REST lub WebSocket.

Edge Computing w systemach wizyjnych

Istotnym trendem w rozwoju systemów wizyjnych jest wykorzystanie przetwarzania brzegowego. Dedykowane urządzenia edge computing, wyposażone w akceleratory AI, pozwalają na realizację zaawansowanego przetwarzania obrazu bezpośrednio w pobliżu robota. Redukuje to latencję systemu i zmniejsza obciążenie sieci przemysłowej. W takich implementacjach często wykorzystuje się protokoły zoptymalizowane pod kątem komunikacji w czasie rzeczywistym, takie jak MQTT czy DDS.

Synchronizacja czasowa stanowi krytyczny aspekt systemów wizyjnych, szczególnie w aplikacjach wymagających precyzyjnego śledzenia obiektów. Implementacja protokołu PTP (Precision Time Protocol) oraz wykorzystanie znaczników czasowych dla danych wizyjnych pozwala na dokładną koordynację ruchu robota z informacjami pochodzącymi z systemu wizyjnego. Jest to szczególnie istotne w aplikacjach typu visual servoing, gdzie dane z kamery bezpośrednio wpływają na trajektorię robota.

Aspekty bezpieczeństwa i wydajności

Bezpieczeństwo komunikacji w systemach wizyjnych wymaga kompleksowego podejścia, obejmującego zarówno zabezpieczenie transmisji danych, jak i ochronę przed manipulacją samym systemem wizyjnym. Standardem staje się implementacja mechanizmów szyfrowania, uwierzytelniania oraz segmentacji sieci przemysłowej. Szczególną uwagę należy zwrócić na zabezpieczenie systemów uczenia maszynowego przed atakami adversarialnymi, które mogłyby prowadzić do błędnej klasyfikacji obiektów.

Optymalizacja wydajności systemu wizyjnego wymaga starannego doboru parametrów komunikacji oraz implementacji mechanizmów buforowania i filtracji danych. W przypadku systemów operujących z wysoką częstotliwością próbkowania, kluczowe jest zapewnienie odpowiedniej przepustowości sieci oraz minimalizacja opóźnień. Coraz częściej wykorzystuje się również mechanizmy predykcji ruchu, pozwalające na kompensację opóźnień w komunikacji.

Kompleksowe aplikacje systemów wizyjnych w robotyce współpracującej

Podsumowując informacje przekazane we wcześniejszych akapitach, należy się przedstawić kluczowe obszary zastosowań tandemu: system wizyzyjny oraz robot współpracujący.

Montaż precyzyjny z dynamiczną lokalizacją komponentów

Zaawansowane aplikacje montażowe wykorzystują systemy wizyjne do precyzyjnego pozycjonowania i weryfikacji elementów. Typowym przykładem jest montaż elementów elektronicznych lub precyzyjnych podzespołów mechanicznych. System wizyjny w takiej aplikacji realizuje:

- ciągłe śledzenie pozycji i orientacji komponentów z dokładnością do 0.1mm

- weryfikację poprawności montażu w czasie rzeczywistym

- dynamiczne dostosowanie ścieżki robota do zmiennej pozycji elementów

- kontrolę jakości połączeń i wykrywanie defektów montażowych

Implementacja wymaga zastosowania kamer o wysokiej rozdzielczości (często powyżej 5MP) oraz zaawansowanych algorytmów przetwarzania obrazu, uwzględniających różne warunki oświetleniowe i możliwe odbicia światła od powierzchni komponentów.

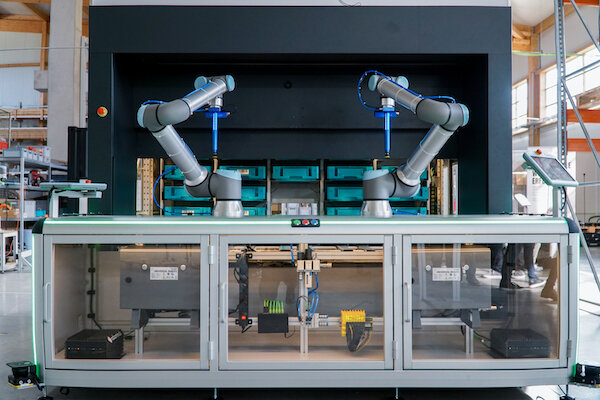

Bin picking z rozpoznawaniem i sortowaniem

Kompleksowe rozwiązania bin picking wykraczają znacznie poza proste pobieranie elementów. Nowoczesne systemy realizują:

- trójwymiarową rekonstrukcję sceny z wykorzystaniem kamer stereowizyjnych lub czujników czasu przelotu,

- klasyfikację i sortowanie elementów według wielu kryteriów (kształt, kolor, oznaczenia),

- planowanie optymalnej kolejności pobierania z uwzględnieniem kolizji,

- adaptacyjne dostosowanie chwytaka do geometrii elementów,

- weryfikację poprawności pobrania i ewentualną korektę położenia.

Szczególnym wyzwaniem jest obsługa elementów o nieregularnych kształtach lub powierzchniach odbijających światło, wymagająca zaawansowanych technik oświetlenia strukturalnego i wielokierunkowej analizy obrazu.

Kontrola jakości z uczeniem maszynowym

Systemy wizyjne w aplikacjach kontroli jakości wykorzystują coraz częściej techniki uczenia głębokiego do:

- wykrywania subtelnych defektów powierzchniowych,

- identyfikacji odchyleń od specyfikacji wymiarowej,

- weryfikacji kompletności montażu,

- oceny jakości powłok i wykończeń powierzchni.

System taki musi działać w czasie rzeczywistym, często integrując dane z wielu kamer i czujników. Kluczowym elementem jest możliwość adaptacji do nowych typów defektów poprzez doszkalanie modeli AI bez konieczności zatrzymywania produkcji.

Współpraca człowiek-robot w elastycznym montażu

Zaawansowane aplikacje współpracy człowiek-robot wymagają kompleksowych systemów wizyjnych realizujących:

- śledzenie pozycji i gestów operatora w przestrzeni roboczej,

- dynamiczną modyfikację trajektorii robota w odpowiedzi na ruch człowieka,

- rozpoznawanie intencji operatora na podstawie analizy kontekstowej,

- weryfikację poprawności wykonywanych operacji montażowych,

- wsparcie operatora poprzez rozszerzoną rzeczywistość.

System musi zapewniać niezawodne działanie w różnych warunkach oświetleniowych i przy częściowym przesłonięciu pola widzenia, wykorzystując często fuzję danych z kamer RGB-D i czujników bezpieczeństwa.

Pakowanie i paletyzacja adaptacyjna

Nowoczesne systemy pakowania wykorzystują widzenie maszynowe do:

- dynamicznej optymalizacji układu produktów na palecie,

- weryfikacji integralności opakowań i kodów identyfikacyjnych,

- adaptacji do różnych rozmiarów i typów produktów,

- kontroli kompletności załadunku,

- wykrywania uszkodzeń opakowań i produktów.

Szczególnym wyzwaniem jest obsługa produktów o zmiennej geometrii lub opakowaniach transparentnych, wymagająca zaawansowanych technik oświetlenia i analizy obrazu.

Obróbka materiałów z dynamicznym śledzeniem ścieżki

W aplikacjach obróbki materiałów, takich jak szlifowanie czy polerowanie, systemy wizyjne realizują:

- ciągłe śledzenie geometrii obrabianej powierzchni,

- adaptację ścieżki narzędzia do rzeczywistego kształtu detalu,

- kontrolę jakości obróbki w czasie rzeczywistym,

- wykrywanie defektów powierzchniowych,

- pptymalizację parametrów obróbki.

System musi radzić sobie z trudnymi warunkami oświetleniowymi i obecnością pyłów czy opiłków, często wykorzystując specjalistyczne filtry optyczne i zaawansowane algorytmy filtracji obrazu.

Obsługa maszyn CNC

Kompleksowe aplikacje współpracy robotów z maszynami CNC wykorzystują systemy wizyjne do:

- precyzyjnego pozycjonowania detali w przestrzeni roboczej maszyny,

- weryfikacji poprawności zamocowania elementów,

- kontroli stanu narzędzi i wykrywania ich zużycia,

- monitorowania procesu obróbki,

- pomiaru wymiarów gotowych elementów.

Implementacja wymaga integracji z systemem sterowania maszyny CNC i precyzyjnej kalibracji układu wizyjnego względem przestrzeni roboczej.

Każda z przedstawionych aplikacji wymaga nie tylko zaawansowanego systemu wizyjnego, ale również kompleksowej integracji z systemem sterowania robota i infrastrukturą produkcyjną. Kluczowym elementem jest zapewnienie niezawodności i powtarzalności działania w warunkach przemysłowych, co często wymaga redundancji systemów pomiarowych i zaawansowanych mechanizmów autokalibracji.

Podsumowanie

Systemy wizyjne stanowią dziś nieodłączny element nowoczesnej robotyki przemysłowej. Ich implementacja pozwala nie tylko na zwiększenie elastyczności i precyzji procesów produkcyjnych, ale często jest kluczowym czynnikiem umożliwiającym realizację zaawansowanych zadań automatyzacji, szczególnie w kontekście Przemysłu 4.0 i produkcji spersonalizowanej.

Jak pokazują przedstawione aplikacje, poprawne wdrożenie systemu wizyjnego to złożony proces wymagający kompleksowego podejścia. Rozpoczyna się od dokładnej analizy potrzeb i warunków produkcyjnych, poprzez staranny dobór komponentów sprzętowych, aż po implementację zaawansowanych algorytmów przetwarzania obrazu i integrację z istniejącymi systemami produkcyjnymi. Kluczowe znaczenie ma również odpowiednie przygotowanie stanowiska pod kątem oświetlenia i warunków środowiskowych.

Złożoność tych systemów może początkowo wydawać się przytłaczająca, jednak przy odpowiednim wsparciu technicznym proces wdrożenia można przeprowadzić sprawnie i skutecznie. Nasz zespół specjalistów posiada doświadczenie w realizacji projektów wizyjnych w różnorodnych aplikacjach przemysłowych. Służymy wsparciem na każdym etapie procesu - od wstępnej koncepcji, poprzez dobór optymalnych rozwiązań, aż po finalną implementację i szkolenie personelu.

Rozpocznij transformację swojej produkcji już dziś

Skontaktuj się z nami!

- Otrzymasz bezpłatną, wstępną analizę wykonalności Twojego projektu.

- Poznasz szczegółową propozycję rozwiązania dostosowanego do Twoich potrzeb.

- Dowiesz się, jak szybko możesz uzyskać zwrot z inwestycji w system wizyjny.

- Zaplanujesz harmonogram wdrożenia minimalizujący ingerencję w bieżącą produkcję.

Umów bezpłatną konsultację:

tycjan.kolecki@elmark.com.pl

+48 605 207 095